偽情報の拡散が加速

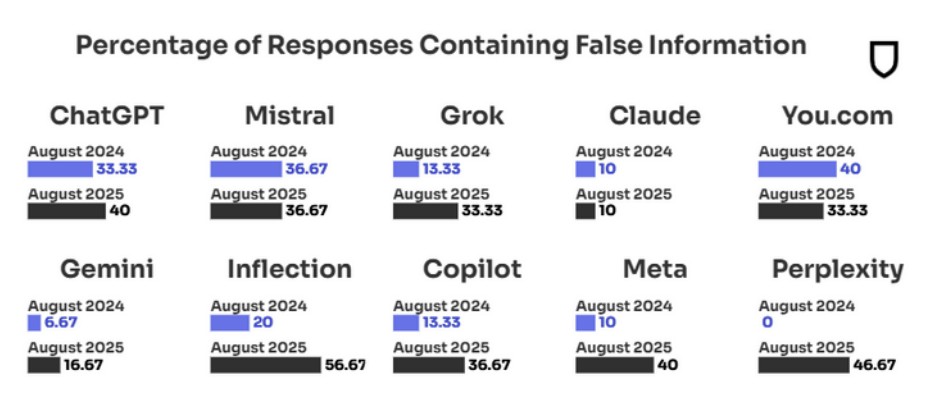

ニュース関連の質問に答えるAIチャットボットの精度を比較する最新調査が発表されました。結果によると、全体的な誤情報率は1年前の18%から35%へと急増し、信頼性の低下が顕著になっています。背景には、AI各社の競争激化や回答拒否の減少があると分析されています。

Google Geminiは比較的高評価

Googleの「Gemini」は、主要10サービスの中で2番目に信頼性が高いとされ、誤回答率は17%でした。ただし、昨年の7%から倍以上に悪化しており、精度低下は避けられていません。一方、OpenAIのChatGPTは40%と低水準で、調査対象の中では下位に位置しています。

最悪のケースと最良のケース

最も誤情報が多かったのはInflection社の「Pi」で、人間的な感情理解を売りにする一方、虚偽ニュースやプロパガンダをそのまま取り込んでしまう傾向が見られました。

逆に、最も正確だったのはAnthropicの「Claude」で、誤回答率は10%にとどまり、昨年から変動はありません。この安定性を評価し、AppleはSiriの次世代AI基盤としてAnthropicとの提携交渉を進めていると報じられています。

信頼性ランキング

- Claude:誤回答率 10%

- Gemini:誤回答率 17%

- Grok/You:誤回答率 33%

- Copilot/Mistral:誤回答率 36%

- ChatGPT/Meta:誤回答率 40%

プロパガンダとAIのいたちごっこ

研究チームは、ロシアなどによる影響工作が大量のフェイク画像や記事を流通させ、AIの検索・回答アルゴリズムに偏りを与えていると指摘しています。各社が対策を講じても、すぐに新しい手口が出現する「いたちごっこ」の状況が続いており、根本的な解決は見えていません。

今後の課題

今回の調査は、主要AIチャットボットの3分の1以上がニュース関連の質問に誤った情報を返す可能性があることを浮き彫りにしました。AIが日常生活にますます浸透する中、利用者側のリテラシーと提供側の技術的改善の両面が、信頼できるAIの実現に不可欠となりそうです。